摘要

快速的技术发展存在创造出极其强大的工具(尤其是人工智能)的风险,而社会还没有机会弄清楚如何最好地以积极的方式使用这些工具来服务多种价值体系。减少痛苦的人可能希望帮助缓解人工智能军备竞赛,以便人工智能开发者承担更少风险,并有更多时间规划如何避免可能由人工智能计算引起的痛苦。机器智能研究所(MIRI)专注于人工智能的工作似乎是解决这个问题的一个重要方法。我建议一些其他更广泛的方法,如提高哲学素养、世界主义视角和社会合作制度。作为一个一般性启发,推进技术的社会影响可能是净负面的,尽管有很多例外,这取决于具体的技术。推进社会科学可能总体上是净正面的。人文学科和纯自然科学也可能是正面的,但每单位努力可能不如社会科学,后者在逻辑上优先于其他一切。我们需要一个更加和平、民主和开明的世界,然后再玩可能对人类未来造成潜在永久性伤害的火。

目录

引言

生活中最悲哀的一面是,科学积累知识的速度远远超过社会积累智慧的速度。--艾萨克·阿西莫夫

原子能的释放改变了一切,除了我们的思维方式[...]。--阿尔伯特·爱因斯坦

技术本质上是一把双刃剑:能力越大,责任越大,我们希望能帮助有知觉的生物的目标也可能导致巨大的痛苦。João Pedro de Magalhaes称之为"爱丽丝的困境",并指出"技术可以拯救生命、丰富我们的梦想,同时也可以毁灭生命、制造噩梦。"

在"智能爆炸:证据与影响"一文中,Luke Muehlhauser和Anna Salamon提出"差异化发展智慧"作为减少人工智能发展相关风险的一种方法。引自面对智能爆炸:

差异化发展智慧包括优先考虑减少风险的智力进步,而不是增加风险的智力进步。具体应用于人工智能风险,差异化发展智慧计划建议我们在人工智能安全的科学、哲学和技术问题上的进展应该超过人工智能能力问题上的进展[...]。

我个人会将那段引文中的"风险"替换为"痛苦",但总体思路是清晰的。

鼓励更多反思

差异化发展智慧在人工智能之外也很重要,尽管因为人工智能很可能控制地球光锥的未来(除非在此之前发生灾难),所以最终所有其他应用都通过它们对人工智能的影响而变得重要。

在一个非常普遍的层面上,我认为激发更深入的哲学思考很重要。世界极其复杂,要产生积极影响需要大量的知识和思考。我们需要更多头脑探索大局问题,比如

- 我们希望看到什么样的未来,希望避免什么样的未来?它们的概率是多少?

- 我们对未来的不同方面有多大控制力?哪些基本上是不可避免的,哪些更依赖于路径选择?

- 我们如何避免对期望过于自信和乐观?是否有一些干预措施可以在广泛的可能情景中都有帮助?

- 我们可以建立什么样的政治、社会和文化制度,以更可靠地促进互利合作?

正如这些问题所暗示的,人类更大的反思能力可以是一个正和(即帕累托改进)的事业,因为一个更缓慢、深思熟虑和头脑清晰的世界是一个所有价值观都有更好前景实现的世界。在人工智能军备竞赛中,有压力要制造出能够获胜的东西,即使它远不如你的团队理想中想要的,也不考虑其他团队想要什么。如果军备竞赛能够受到限制,那么就有更多时间就人工智能应该如何塑造进行正和妥协。这在期望上有利于所有各方,包括减少痛苦的人,因为匆忙建造的人工智能不太可能包括防止有知觉的科学模拟、痛苦子程序等的安全措施。

提高反思能力的想法

MIRI在人工智能相关的哲学和战略问题上做了重要工作,并就这个话题写了很多。下面我讨论一些其他更广泛的差异化发展智慧方法,但总的来说,MIRI直接关注人工智能可能是最有效的。

文科教育

社会科学和人文学科包含大量关于人类价值观、亲社会行为策略以及哲学家Nick Bostrom所称的"关键考虑因素"的重要见解,这些见解有助于理解宇宙如何运作以及如何对其产生积极影响。鼓励人们探索这些材料很好,比如通过文科教育。

文科实际上是高等教育的核心。职业教育是一种工具,但文科代表了我们最好的价值观,它们培养批判性思维[...] 当高等教育经常被主要视为职业教育时,文科、人文学科和社会科学是如此重要。

当然,纯粹关注人文或社会科学也不是一个好主意,因为硬科学教导一种思维清晰度,可以消除一些困扰标准哲学的困惑。此外,由于最终目标之一是以更积极和合作的方向塑造技术进步,有反思能力的思想家需要对科学和技术有深入了解,而不仅仅是大卫·休谟和彼得·辛格。

大局观的世界主义思维

除了学生在学校学到的知识外,还应当更广泛地拓展人们的思维。当科学家、政策制定者、选民和其他决策者意识到更多看待世界的方式时,他们更有可能保持开放心态,考虑他们的行为如何影响所有相关方,即使那些可能与自己感受不同的人。宽容和世界主义理解似乎对减少零和的"我们对他们"斗争很重要,并意识到我们可以从彼此的差异中学习 - 无论是智力上还是道德上。

TED演讲、Edge以及成千上万类似的论坛是拓展思维、推进关于大局问题的社会讨论以及希望打破人与人之间界限的重要方式。

虽然科普有助于让非专家了解即将到来的事物,从而推进对如何前进的关键考虑因素的洞察,但它也带来了同时鼓励更多人进入科学领域并更快产生发现的风险。净平衡并不明显,尽管我猜对于许多"纯"科学(数学、物理、生态学、古生物学等)来说,净平衡是正面的;对于那些有更多技术应用的科学(计算机科学、神经科学,当然还有人工智能本身),这个问题更加模糊。

有效利他主义

扩大有效利他主义(EA)运动是另一项正和活动,因为EA旨在帮助回答关于如何最好地塑造未来以造福许多不

改进公共政策认识论

Carl Shulman提出以下想法:

- 通过诸如IARPA预测锦标赛、科学法庭等方式增强决策和预测能力,以改善对包括人工智能在内的发展的反应(回想一下,在[Eliezer Yudkowsky]的模型中,MIRI大部分价值来自主要机构在未来对人工智能集体愚蠢或无知)

- 预测市场、元研究和其他制度变革[.]

这些及相关提议会间接加速技术发展,这是一个反面考虑因素。此外,如果被军方使用,它们会加速军备竞赛吗?即使是正面的,也不清楚这些方法对负面倾向的功利主义者来说是否具有与其他更哲学的干预措施相同的价值,后者似乎更有可能鼓励同情和宽容。

这些元层面的事情是否具有成本效益?

鼓励哲学反思是否可能与更直接的工作(如探索人工智能的哲学后果)在每美元的重要性上具有竞争力?我猜直接工作(如MIRI的工作)每美元更重要。话虽如此,我怀疑成本效益的差异并不巨大,因为社会中的一切都对其他一切产生流动效应,随着人们在哲学上变得更加复杂和全面,他们更有可能识别出最重要的重点领域,而人工智能哲学只是其中之一。另一个重要的重点领域可能是,例如,设计国际政治结构,使合作开发人工智能成为可能,从而减少无约束军备竞赛的无谓损失。这可能有利于所有各方,包括减少痛苦的人,因为匆忙建造的人工智能不太可能包括防止有知觉的科学模拟、痛苦子程序等的安全措施。可能还有许多其他尚未探索的此类干预措施,一般鼓励更多思考这些话题是促进这种探索的一种方式。

我在这次讨论中的部分目的不是提出一个高度优化的慈善干预措施,而只是提出一些关于我们应该如何看待其他事情的副作用的暂定结论。例如,我应该在Facebook和YouTube上点赞那些促进智力反思的内容吗?可能应该。我应该鼓励我的表弟学习物理+哲学还是电气工程?这些考虑因素会稍微更倾向于物理+哲学,而不是你之前可能会推荐的。诸如此类。

理想主义遇到竞争约束

本文中提出的许多想法都是陈词滥调 - 在毕业典礼或说教性电视节目上提出的观察,关于拓展人们的思维,使他们能够更好地和谐共处。这不是太天真了吗?未来是由经济竞争、权力政治、穴居人情绪和其他大规模进化压力驱动的,所以我们真的能仅仅通过改变人心来产生影响吗?

确实,未来的很大一部分可能不受我们控制。事实上,现在的很大一部分也不受我们控制。即使政治领导人也经常受到说客、捐助者和支持率的约束。但是政治家的个人决定可以对结果产生一些影响,当然,选民和捐助者的观点和财富分配本身就受到社会中思想的影响。

许多社会规范源于惯例或权宜之计,因为信念往往跟随行动而不是先于行动。尽管如此,社会倾向于接受的模因肯定有一定的余地,我们可以直接或间接地拉动这些模因。世界主要宗教的创始人对历史进程产生了巨大而非必然的影响。过去和现在的其他作家和思想家也是如此。

另一个考虑因素是,我们不希望有选择性的反思。例如,假设那些目前追求快速技术突破的人继续以同样的速度前进,而社会其他人则放慢脚步,更仔细地思考如何前进。这可能会使情况变得更糟,因为那样反思就更没有机会赢得这场竞赛。相反,我们希望看到的是对探索我们希望如何使用未来技术的社会和哲学方面的全面认识 - 一种希望能影响所有国家的所有各方的认识。

作为一个具体的例子,假设美国放慢了技术增长,而中国没有。中国目前对动物福利的关注较少,总体上治理也更专制,所以即使从非种族中心主义的角度来看,让中国控制未来也可能稍微更糟。但我认为,与整个地球更快技术发展的直接、可能有害的影响相比,这种考虑因素非常小,特别是因为大多数非军事技术进步并不局限于国界内。中国可能会在几十年内赶上美国的人道关怀水平,而世界整体前进的速度似乎是一个更大的问题。此外,在军事技术方面,美国往往引领创新步伐,美国军事技术增长放缓可能会减少其他国家军事技术发展的压力。

影响不明确的领域

更快的技术

加速技术并不总是更危险。例如,某些领域(如使维基百科成为可能的互联网)的更快技术加速了智慧的传播。科学发现可以帮助我们在短期内更快地减少痛苦,并改善我们对人类应该追求哪些长期轨迹的评估。等等。技术几乎总是利弊兼具,某些领域的更快增长可能是非常有益的。然而,从宏观角度来看,影响并不那么明确。

教育

全面推进教育是另一把双刃剑,因为它既加速技术又加速智慧。然而,差异化推进跨学科和富有哲学思想的教育似乎普遍对许多价值体系(包括减少痛苦)都是有利的。

认知增强

在"智能放大和友好人工智能"一文中,Luke Muehlhauser列举了提高认知能力可能帮助和损害控制人工智能机会的论点。Nick Bostrom在《超级智能:路径、危险、策略》第14章中回顾了类似的考虑因素。

超人类主义

好处:

- 超人类主义者认识到提前思考未来的重要性。

- 他们在某种程度上关心可能展开的未来痛苦风险。

缺点:

- 超人类主义者通常希望加速未来,可能是由于过于乐观的态度。

- 超人类主义者通常支持殖民太空和广泛传播知觉,尽管这可能意味着预期痛苦的大幅增加。

经济增长

经济增长是一个类似的双刃剑,尽管可能不那么戏剧性。经济增长的一个主要影响是技术增长,就我们需要更多时间反思而言,这似乎是一种风险。另一方面,经济增长有几个更可能是积极的结果,比如

- 增加国际贸易,附带效果是使人们更同情其他国籍的人,减少国家间战争的可能性

- 促进民主,这是解决冲突派系之间争端的强有力方式

- 增强稳定性,从而更关注长期结果,减少单方面冒险

- 总体上允许更多智力意识和对重要问题的反思。

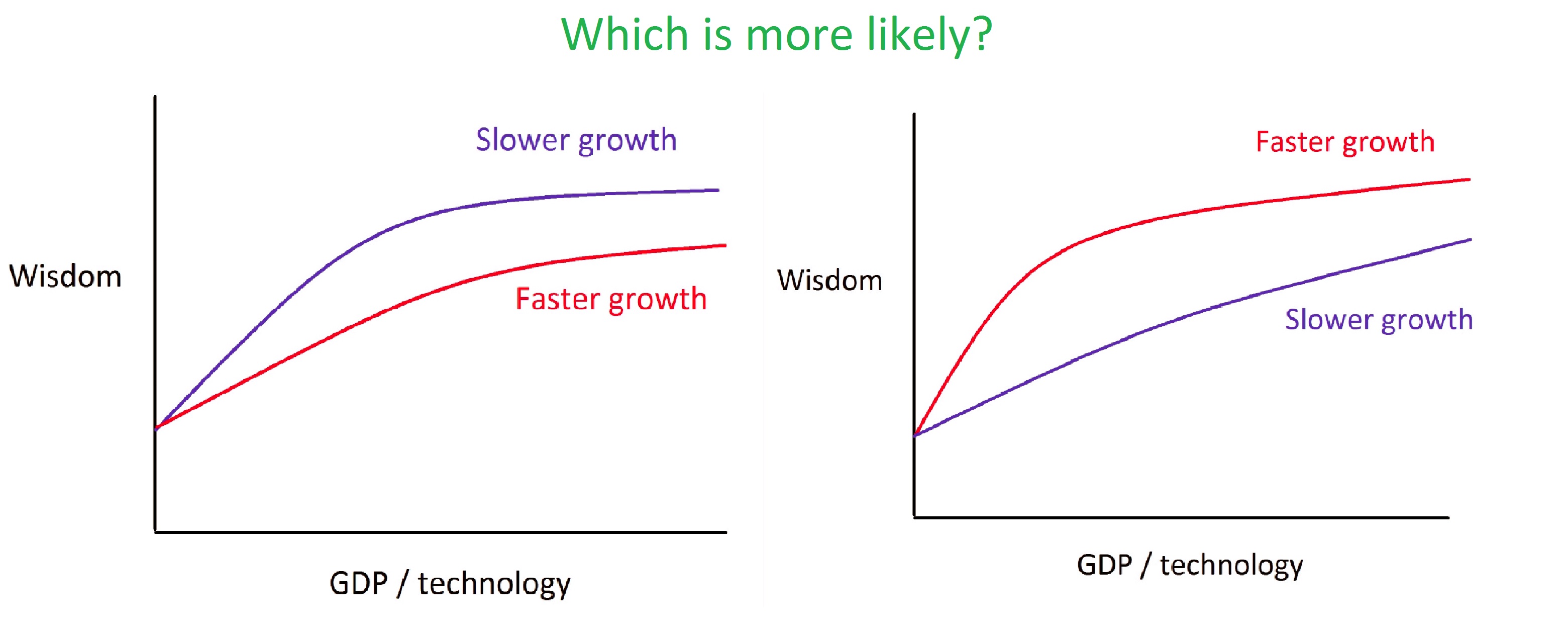

话虽如此,这些似乎是经济产出绝对数量的属性,而不是经济增长率的属性。一个更富裕的世界会更有反思能力,这一点并不存在争议,但问题是如果世界增长更快或更慢,它是否会每单位GDP更有反思能力。(注意:在下图中,x轴代表"GDP和/或技术",而不是"GDP除以技术"。)

作为一个提示性的类比,生长较慢的晶体缺陷较少。在模拟退火算法中更慢地降低温度允许找到更好的解决方案。在经济增长的情况下,人们可能会说,如果人们有更多时间适应给定水平的技术能力,他们可以在进入下一个水平之前使条件变得更好。因此,例如,如果当前全球暴力水平降低的趋势继续下去,我们宁愿等待更长时间才能增长,这样当增长发生时世界可以更加和平。当然,这种和平趋势本身可能部分是由经济增长引起的。

想象一下,如果中世纪的人们非常迅速地发展技术,到了几乎可以构建通用人工智能的地步。当然,他们也会迅速改善他们的信念和制度,但这些改进无法与我们实际世界通过等待几个世纪而获得的额外智慧相竞争。中世纪的人工智能建造者会由于理解不足、哲学不够复杂、政治结构较差、社会规范较差等原因而做出更糟糕的决定。历史的弧线几乎单调地朝着这些重要维度的改善方向发展。

一个反驳论点是,现在条件相当不错,如果我们等待太久,它们可能会在此期间变得更糟,比如因为美国和中国之间的另一场冷战。或者,也许更快的经济增长意味着更快的贸易,这有助于在短期内防止战争。(例如,如果美国和苏联是重要的贸易伙伴,是否就不会有冷战?)一位朋友告诉我,Peter Thiel认为增长对合作很重要,因为在增长情况下,激励是正和的,而在停滞情况下,它们更多是零和的。Carl Shulman指出"人均繁荣和人均收入增长与更自由的后物质主义价值观、稳定的民主和和平相关。"通过生育率以外的方式实现更快增长可能会增加人均GDP,因为增长会比人口增长更快。

假设人工智能会

假设人工智能会在地球达到某个特定GDP水平时到来。那么即使我们看到更快的增长与更快的宽容、合作和智慧增长相关,这也不一定意味着我们应该推动更快的增长。问题是,当增长更快或更慢时,GDP的某个百分比增长是否会带来更多的智慧增长。

或者,在一个模型中,无论是否有GDP增长,人工智能都会在地球累积GDP历史达到某个数量后到来,那么如果零GDP增长意味着零道德增长(这显然是不现实的),那么我们会更喜欢有更多GDP增长,这样当人工智能到来时我们会有更多智慧。

Carl Shulman指出的另一个相关考虑因素是,人工智能技术的增长可能只与整体经济增长松散耦合。事实上,如果增长放缓导致战争引发人工智能军备竞赛,那么更慢的经济增长会意味着更快的人工智能。当然,有些人持相反观点:环保主义者可能声称,更快的增长会意味着更多未来灾难,如气候变化和水资源短缺,这些会导致更多战争。技术专家则回应说,更快的增长意味着更快的方法来缓解环境灾难。如此等等。

此外,一个国家需要一定水平的经济繁荣才能开始积累危险武器,有时经济衰退可能会将平衡推向"黄油"而不是"枪支"。David E. Jeremiah预测"随着更多国家获得利用更先进技术的财富,常规武器扩散将增加。"在"核军控的下一步"演讲中,Steven Pifer建议经济状况恶化可能会激励俄罗斯支持裁军协议,以减少它难以支付的昂贵武器。当然,也可能出现相反的情况可能发生:如果预算紧张,一个国家在开发新技术时可能会剥离风险分析、确保技术对社会有益等"奢侈品"。

第三世界国家的更多发展可能意味着更多国家总体上能够参与技术军备竞赛,使协调更加困难。例如,许多非洲国家可能太穷而无法追求核武器,但像印度、巴基斯坦和伊朗这样稍微富裕的国家可以这样做。另一方面,贫困国家的发展可能意味着更多民主、和平和加入全球治理机构的倾向。

结果并不明确。无论如何,即使更快的经济增长是积极的,在大多数情况下,推进经济增长似乎不太可能是最具成本效益的干预措施,特别是因为已经有强大的竞争和政治压力在推动它。当然,在某些情况下,政治压力在另一个方向更强(例如,反对开放移民边界),当存在国家和全球经济蛋糕之间的感知冲突时。

此外,虽然"经济增长"作为一个抽象概念的影响可能相当分散和双面,但任何特定的增加经济增长的干预措施可能都会朝着一个特定方向针对,在那里技术与智慧之间的差异影响更加单方面。

战争和军备竞赛可能占主导地位

引用LessWrong上的Kawoomba的话:

研发,特别是基础工作,占全球GDP的比例如此之小,以至于任何旧效应都可能主导它。例如,中美之间的"冷战"式情景会减缓经济增长 - 但会强烈加速高科技双用途技术的研究。

虽然我们在想到技术研究时经常想到"谷歌",但就花费的资源而言,我们应该主要想到国防部 - 国家行为体在研究投资方面传统上远远超过跨国公司,而他们的[投资]是被经济增长放缓所刺激还是抑制(取决于未指明的增长放缓原因)是任何人的猜测。

Luke_A_Somers跟进道:

是的 - 我认为高增长和完全和平的情况会比反过来好得多。公司似乎更有可能满足于工具人工智能(或者至少是具有固定认知算法的人工智能,即使它可以学习事实),而不是,比如说,一个处于战争状态的国家。

避免冲突和军备竞赛的重要性在"灾难性风险如何影响妥协前景?"一文中有详细阐述。

总的来说,战争是许多价值体系"失去盈余"的主要来源,因为每一方都会产生成本,资源被浪费,竞赛可能迫使各方采取短视行动,可能对减少未来盈余产生长期后果。当然,战争的许多后果似乎是暂时的;我不确定"永久失去未来盈余"的担忧有多大。

经济增长是否会减少军备竞赛的风险并不明显。在富裕国家之间,它可能会,因为更多的贸易和繁荣通常会导致更大的相互依存和宽容。另一方面,更多的财富也意味着更多可支配收入用于技术。贫困国家的经济增长可能会加剧军备竞赛,因为随着更多国家发展,竞争各方会增加。(例如,在不久的将来,发达世界和贫困非洲国家之间不存在军备竞赛风险。)但国际发展也可能加速全球协调。

有很多例外

我在上一节中的评估是极其宽泛的概括。它们类似于"女孩在语言方面比男孩更好"这样的说法 - 平均来说是正确的,但个体测量的分布有很大重叠。同样,关于技术和社会制度的说法也是如此:每个类别中都有很多非常好的进步和很多非常糟糕的进步,特定活动的影响可能与该类别的平均影响非常不同。对类别进行概括的主要原因是为了对政策进行高层次评估,比如"我们应该支持美国更多的工程项目资金吗?"当评估特定活动(比如你的职业)时,仅仅将其标记为"技术"或"社会科学"远不如对该活动进行具体分析有帮助。

可能不宜加速的技术

计算机硬件

在《超级智能》(第14章)中,Bostrom概述了为什么更快的硬件可能会使人工智能控制变得更加困难的原因:

- 它可能会加速通用人工智能,给反思和合作留下更少时间。

- 它可能会有利于更加暴力和不透明的人工智能形式,这些形式似乎更难预测和与我们的价值观保持一致。(我要补充的是,这一点是有争议的,取决于如何应用暴力。脑仿真是一种暴力形式的人工智能,实际上可能更容易控制。即使是通过遗传算法进化的头脑在重要方面也可能更像人类,而不是严格的数学人工智能。)

- 它可能会造成"计算过剩",即比开发人工智能软件的专业知识更多的硬件能力。这意味着当人工智能软件的关键洞见被开发出来时,起飞可能会更加突然。

- 它会降低创造通用人工智能的资源要求,可能允许更多方参与人工智能军备竞赛,包括更极端的团体。

- 虽然一些计算机技术(如互联网)可能会加速智慧,但不清楚边际硬件改进会在这些方面进一步贡献多少。

人工意识

人工意识似乎推进起来是有害的,因为

- 它有助于加速人工智能的总体发展。

- 最好等到社会更加明智和人道时再开发有意识的计算机代理。例如,想象一下以能够产生有意识、栩栩如生的敌人而销售的暴力视频游戏。

Steve Grand为他在人工意识生物方面的工作辩护如下:

这就是我关心的。我想帮助我们找出意识是什么意思,我想挑战人们自己问一些他们无法对自然生命提出的困难问题,因为他们有未经质疑的假设和偏见。但我们真的在谈论的是按自然标准极其简单的生物。我试图探索的是拥有想象力意味着什么。不是像人类那样丰富的想象力,而是任何想象力。唯一找出答案的方法就是尝试构建一个,看看为什么需要它以及它需要什么。通过这样做,我可以帮助人们问一些关于他们是谁、其他生物是谁以及活着意味着什么的问题。这不是一件坏事,对吧?

这类似于Bostrom在《超级智能》第14章中称之为"二次猜测"的论点实例:基本上,为了让人们认真对待一项技术的风险,你需要推进该技术的工作,最好在技术潜力有限时这样做,以限制风险。换句话说,我们应该在技术的"能力过剩"积累之前推进技术,否则可能会导致更突然和危险的技术进步。Bostrom和我都持怀疑态度。有了这样的辩护,人们可以为任何技术速度立场辩护,因为要么我们(a)减缓技术以留出更多反思时间,要么(b)加速技术,以便其他人在风险仍然可控的情况下更认真地对待风险。

在人工意识的情况下,我们应该通过专注于哲学而不是构建软件头脑的技术细节来推进公共讨论。已经有足够的人工意识技术工作来推动大量哲学对话了。

注意事项:什么时候变化实际上是正和的?

资源正和不意味着效用正和

提高社会智慧在资源方面是正和的:因为他们知道得更多,他们可以更好地实现各自的目标。他们有更多工具从环境中提取价值。然而,一个改善许多方资源的行动并不总是改善每个方效

然而,一个改善许多方资源的行动并不总是改善每个方效用的行动。当各方目标冲突时可能会出现例外。

以一个玩具例子为例。假设地球只包含石器时代的人类。一个部落认为地球在未受触动的自然状态下是美丽的。另一个部落认为应该改造地球以更好地服务人类经济利益。如果这些人类永远停留在石器时代,没有更多智慧,那么支持保护的阵营将默认获胜。相比之下,如果你增加两个部落的智慧 - 平等或甚至更多地增加支持保护的部落 - 那么现在支持发展的部落至少有可能成功。因此,尽管智慧增加是正和的,支持保护的部落现在在期望效用上更糟。

然而,这个例子有些误导。本文的一个要点是强调更大技术的潜在风险,智慧之所以有益,部分原因是它更好地允许双方合作并找到减少预期危害的解决方案。例如,没有智慧,支持发展的人可能会直接与支持保护的人开战,如果支持发展的一方获胜,支持保护的一方的价值观将被彻底摧毁。如果双方同意进行适度发展,同时保护自然,那么每一方在期望上都可能更好。这是智慧可以带来正和效用收益的一个例子。

也许有一些例子,智慧本身,而不仅仅是技术,会对某种意识形态造成净损害,但总的来说,智慧似乎通常对许多派系来说在效用上是正和的。

变化是由人口比例还是绝对数量决定的?

为什么智慧和相关改进应该是正和的主要直觉是,它们保持不同价值观的人的比例不变,而是将更多的"蛋糕"分配给每组价值观的人。这种分数观点在某些情况下是有意义的,比如在选举中,投票比例是相关的。然而,在其他情况下,拥有某些价值观的人的绝对数量似乎是更合适的衡量标准。

作为一个例子,考虑灾难避难所的情况,这些避难所旨在在接近灭绝级别的灾难后备份文明。许多利他主义者支持灾难避难所,因为他们希望人类能够殖民太空。像我这样的减少痛苦的人可能反对灾难避难所,因为避难所增加了太空殖民的可能性,而没有相应增加更人道价值观的可能性。如果对灾难避难所的工作与(支持的人数)减去(反对的人数)成正比,并且假设默认90%的人支持它们,那么更多教育可能会将

(10人支持)减去(1人反对) = 9净支持

变为

(1000人支持)减去(100人反对) = 900净支持,

这是对灾难避难所资源的100倍增加。这使减少痛苦的人处于更糟糕的境地,所以在这种情况下,教育并不是正和的。

我对智慧、教育、合作等通常是正和的直觉,假设人们因这些变化而做的大部分工作对增加幸福和减少痛苦的人来说都是内在积极的。灾难避难所似乎是这一总体趋势的一个明显例外,我希望不会有太多其他例外。减少痛苦的人应该警惕其他看似正和的干预可能实际上会损害他们价值观的情况。

另见

- Paul Christiano的"关于进步与繁荣"