摘要

在尝试将通用人工智能(AGI)与人类价值观对齐时,存在着大体正确但略有偏差的可能性,这可能会产生灾难性的后果。这些"近乎命中"(near miss)的情况中,有些可能导致巨量痛苦。在某些近乎命中的情况下,更好地推广你的价值观反而可能使未来变得更糟。

目录

引言

人类的价值观只占所有可能价值观的极小部分。我们可以想象出一个广阔的人工智能心智空间,它们优化的目标与人类关心的事物大相径庭。一个玩具例子是所谓的"回形针最大化"AGI,它的目标是最大化宇宙中预期的回形针数量。许多AGI对齐方法希望教会AGI人类关心什么,以便AGI能够为这些价值观进行优化。

当我们将AGI从"回形针最大化"转向关心人类价值观时,我们增加了几乎但不完全正确地实现对齐的概率,这被称为"近乎命中"。许多近乎命中的AGI可能比回形针最大化AGI产生更多痛苦,这是很有可能的,因为一些近乎命中的AGI会创造出更接近人类同情对象的生物。

另请参阅David Althaus在2014年对近乎命中的解释。

术语说明

韦氏词典对"近乎命中"的定义之一是"差一点就成功的事情"。这就是我在本文中所指的意思。

应用于普通人类事故的"近乎命中"一词指的是"一个没有造成财产损失和人员伤害的事件,但如果时间或位置稍有偏移,很容易就会造成损害或伤害"(维基百科"近乎命中(安全)")。对于AGI对齐来说,"近乎命中"是一个相反的概念:正是因为对齐略有偏差,可能会导致大量伤害和痛苦。

近乎命中的例子

以下是两个近乎命中场景的例子。第一个,符号翻转,是一个有点玩笑意味的例子,希望是不现实的,但有助于说明基本概念。第二个,配置错误的心智,可能稍微更现实一些,尽管它也应该被视为过于简单化。

符号翻转

近乎命中的典型例子可能是以下情况。想象一个AGI包含了人类效用函数V的完美表示(假设为了这个例子,人类甚至有一个单一的、连贯的效用函数)。人类告诉AGI去"最大化V"。然而,假设"一个宇宙射线翻转了AGI有效效用函数的符号"("Separation ...", n.d.)变成-V。AGI现在将最大化-V,这等同于最小化V。在宇宙尺度上最小化人类价值观将是可怕的——根据定义,这是我们未来光锥内最糟糕的可能结果。AGI将扩散到其所能到达的所有星系,用强烈的折磨、死亡和其他人类认为邪恶的事物填满它们。

宇宙射线的问题可以通过使用纠错码内存等方法来克服。稍微更令人担忧的可能是人为的符号错误。在大学时,我记得有些物理问题我得到了正确的答案,只是缺少一个负号,或者我有一个不应该有的负号。当然,这种风险也可以通过各种理智检查、独立开发团队冗余指定效用函数等方法来缓解。

一个现实世界中类似符号翻转错误的例子,是在书面指令而不是效用函数层面上发生的,那就是2016年美国总统候选人希拉里·克林顿竞选主席约翰·波德斯塔的电子邮件被黑客入侵。Uchill (2016):

波德斯塔收到一封据称来自谷歌的电子邮件,称黑客试图入侵他的Gmail账户。当一名助手给竞选团队的IT人员发邮件询问这个通知是否真实时,克林顿竞选助手Charles Delavan回复说这是"一封合法的电子邮件",波德斯塔应该"立即更改他的密码"。

他本应该告诉助手这封邮件是一个威胁,一个好的回应是直接通过谷歌网站更改密码,但他无意中告诉助手点击欺诈性邮件并给攻击者访问账户的权限。

Delavan告诉《纽约时报》,他本打算输入"非法",这是一个他至今仍无法原谅自己犯下的打字错误。

如果Delavan写了一个完全正确的回复或一个胡言乱语的回复,事情就会没事。正是因为他写了一个几乎完美但略有错误的回复,才导致了与预期相反的结果。

配置错误的心智

假设人类要求他们的AGI用尽可能多的快乐生物填满未来的光锥。AGI试图这样做,但它对"快乐心智"的解释略有偏差,导致它创造出有点异常的大脑。这些心智可能会遭受严重的心理健康问题,导致生活质量非常低。

幸运的是,配置错误的心智中的痛苦密度似乎远低于符号翻转中的密度,因为在配置错误的心智中,痛苦只是附带的,而不是直接被优化的。然而,一个充满忍受抑郁、焦虑、精神分裂症或其他精神疾病的心智的宇宙仍然是一个可怕的结果。

当传播你的价值观是有害的

一些近乎命中的场景,特别是符号翻转,属于"效用函数否定"的范畴。在这些情况下,推广效用函数U往往会使事情变得更糟(根据U)。在符号翻转中,人类越精确地指定他们的价值观,结果就越糟糕,因为AGI可以更精确地优化这些价值观的最小值。如果你持有大多数人类不认同的独特道德观点,在符号翻转场景中,你最好不要推广那个观点。例如,如果你认为昆虫值得道德考虑,而大多数人类不关心昆虫,那么在符号翻转场景中,如果你成功说服更多人关心昆虫,你就更有可能让天文数字的受折磨的蚂蚁和蟑螂成为我们未来的一部分。

在配置错误的心智场景中,推广对非人类动物的关注也可能是有害的吗?也许是。一个原因是,相对于道德上有价值的意识单位,非人类动物可能更便宜计算。例如,一头牛有大约30亿个神经元(Herculano-Houzel 2016,引自Shulman 2013),而人类有850亿个,所以也许模拟大约85/3 = 28头牛的成本相当于模拟一个人类。a但许多动物倡导者认为一头牛的价值远超过人类的1/28。因此,相对于这些价值观,通过模拟牛而不是模拟人类可以创造更多的总意识。因此,如果实现了配置错误的心智,相对于许多动物倡导者的价值观,一个充满牛的未来会包含更多的总意识,因此也会包含更多的总痛苦,比一个充满人类的配置错误的心智未来。

这一点在反基质主义活动中可能更加明显,假设非生物意识的生产效率远高于生物意识,相对于反基质主义倡导者的价值观。如果生物沙文主义盛行,那么配置错误的心智未来将"只"包含可以容纳在我们未来光锥内的生物心智,而如果反基质主义盛行,则可以在我们的未来光锥内创造出更多的受苦心智。

但传播你的价值观肯定仍然是期望为正的吧?

尽管存在近乎命中的风险,但人们很容易假设传播自己的价值观仍然可能是一件好事,因为在非近乎命中的情况下,让未来几代人和AGI关心你所关心的事情是非常有价值的。我认为这通常是正确的,但这取决于具体情况。

如果你试图最大化当前稀少的东西,比如回形针或幸福,那么近乎命中可能不是一个大问题,因为如果效用函数被否定,"下降"的空间不大。例如,大多数未来场景中的回形针数量相对于可能生产的数量来说是微不足道的。人类将继续使用回形针几十年,也许一些后人类模拟中会包含一些回形针,但除此之外,大多数未来将相当缺乏这些办公用品。因此,如果回形针最大化的价值观变异成回形针最小化的价值观,未来的光锥将只失去相对于默认轨迹而言微不足道的回形针数量。与回形针最大化价值观不发生变异时可能产生的天文数字的回形针相比,近乎命中的风险似乎可以忽略不计。

然而,如果你的目标是最小化宇宙中当前稀少的东西,比如痛苦,那么就有巨大的空间使事情变得更糟,而只有很小的空间使事情变得更好。默认情况下,也许我们未来的光锥在期望值上只会包含可能创造的痛苦的10-6。由于符号翻转会创造尽可能多的痛苦,如果符号翻转的概率大于10-6,那么根据这个简单的计算,反对痛苦的价值观的存在在期望值上就是负面的。

我对这种考虑是否实际上使关注痛苦成为净负面没有全面的看法。我怀疑,至少在能够进一步研究这些难题的人群中,关注痛苦是相当积极的,而更广泛的社会对痛苦的关注有助于创造更多关注痛苦的研究者。然而,不太清楚的是,是否将关注痛苦明确地指定到AGI中是积极的。

负向功利主义vs经典功利主义

在更好地指定你的效用函数是有害的情况下,负向功利主义者(negative utilitarian)是否应该实际上倾向于经典功利主义(classical utilitarian),因为它离他们的价值观更远?至少在符号翻转的情况下,这不会有什么区别,因为负向功利主义和经典功利主义共享相同的效用函数最小值。对于符号翻转场景来说,比负向或经典功利主义更好的是"正向功利主义"(positive utilitarian)——只有幸福重要,痛苦不重要的观点。正向功利主义将允许在非近乎命中场景中创造幸福的上升空间,而不会在符号翻转场景中优化痛苦的下降空间。(也许这是严格的正向功利主义唯一的好论据。:) )

对于配置错误的心智场景,负向功利主义最能避免风险,因为负向功利主义者一开始就不会试图用快乐的心智填满未来的光锥,而经典和积极功利主义者可能会这样做。所以在面对近乎命中时,哪种价值理论最安全取决于具体的场景。

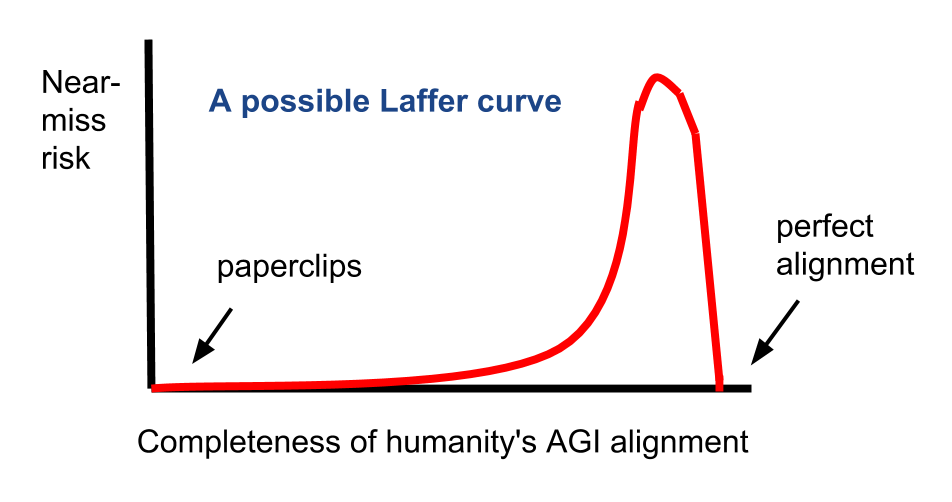

对齐研究的拉弗曲线

对齐和未对齐的AGI都可能以各种不同的方式产生巨量痛苦。然而,如果我们只关注近乎命中的风险,那么我们会看到类似于拉弗曲线的近乎命中风险,作为人类进行AGI对齐研究程度的函数。如果不进行对齐研究,导致回形针最大化类型的未来,那么近乎命中的风险基本上为零,因为AGI开发根本没有指向人类价值观的方向。同时,如果进行完美的对齐研究,那么AGI将完全与人类价值观对齐,也不会有近乎命中。在这两个极端之间,存在近乎命中的风险,在某个点达到最大值。

那么,进一步的对齐研究是减少还是增加近乎命中的风险,取决于现状是在最大近乎命中风险点的左侧还是右侧。当然,也要记住,对于许多价值体系来说,尽管存在近乎命中的风险,但进行AGI对齐仍有重大好处,因为没有它,积极的价值观如幸福就不会被优化。

如果一个人关心近乎命中,那么可能有比仅仅上下调整人类进行标准AGI对齐研究的数量更有影响力的方法来产生影响。特别是,人们可以推动更多关于避免近乎命中的研究,包括"与超存在风险分离"的原则。

近乎命中是否比完全失准或完全命中更糟?

关于上图,重要的是要记住,y轴只显示了近乎命中的风险,而不是其他形式的痛苦风险。我认为近乎命中的AGI是否比回形针制造AGI或人类对齐的AGI带来更多的总痛苦风险并不明显。例如:

- 虽然配置错误的心智AGI创造了巨大的痛苦,但也许它正确反映了人类价值观,足以知道要最小化创造处于绝对最糟糕形式痛苦中的人类和动物,比如被活活吃掉或遭受身体折磨,而回形针制造AGI在执行工具性有用的计算任务时,对模拟处于难以忍受痛苦中的人类和动物没有内在的抑制。

- 许多近乎命中的AGI可能会扭曲人类对意识的理解,导致这些AGI创造的意识(因此可能是痛苦)远远少于人类对齐的AGI,特别是如果人类对齐的AGI不仅体现纯粹天使般的人类冲动。

话虽如此,某些近乎命中的AGI子集——即符号翻转和更现实的符号翻转附近的AGI——可能是如此具有破坏性,以至于即使它们的可能性很低,也可能导致我们得出结论,近乎命中的AGI确实比其他AGI更危险。然而,我对这个话题还不够了解,无法有坚定的意见。

人类情境中的近乎命中

"近乎命中灾难"的一般定义可能是这样一种情况:当行为者A试图向行为者B指定一个目标或结果时,原始意图略有修改,导致比A没有试图向B指定任何东西时更糟糕的结果。这种情况在日常生活中实际上相当常见,这有助于表明近乎命中风险的想法并非纯粹的猜测。

考虑以下例子。动物倡导者Anthony想要传播对其他有情众生的同情心,以便更多的人类会想要保护动物和环境。Anthony说服的人中有Briana,她深深关心痛苦。Briana注意到荒野中包含了多少难以解决的痛苦,并推理出减少这种痛苦的最好方法是减少荒野本身。她开始为减少野生动物栖息地而奔走,这让Anthony感到恐惧。相对于Anthony的价值观,这是一个近乎命中的灾难,因为只有因为Briana如此关心动物,她才专注于防止它们的存在。如果Briana反而把时间花在一些无关的话题上,比如集邮,从Anthony的角度来看,事情就会很好。

所以近乎命中的灾难甚至可能发生在单一AGI去优化指定的效用函数的场景之外。这表明近乎命中的动态在"软AGI接管"轨迹中也可能令人担忧,尽管需要进一步的工作来充实这样的场景。

另一个例子:放生

以下引文描述了人类世界中另一个近乎命中的例子。Actman (2017):

根据He Yun和其他专家的说法,一个曾经鼓励自发释放注定死亡动物的传统,如今已经变成了一种商业企业,人们专门购买动物以释放它们。这个过程可能会伤害——甚至杀死——它们。[...]

"动物经常被捕获,被关在恶劣的条件下,被释放,然后经常再次被捕获,"Palmer说。《当代佛教》杂志引用的一篇文章描述了这样一种情况:佛教组织从零售商那里大量订购鸟类以释放,只是猎人等着捕捉被释放的鸟类,然后整个循环又重新开始。

如果人类根本不关心动物的福利,放生也就不会存在。当然,在我们当前的世界中,人类对动物的关心可能总体上减少的痛苦远多于它创造的痛苦。但在未来的近乎命中场景中可能并非如此,在这些场景中,关心痛苦的可能下行空间可能远远超过可能的上行空间。

近乎命中的AGI vs 人类价值观漂移

近乎命中的AGI的价值观的一个粗略模型可能是人类价值观加上一些随机噪音。如果近乎命中的AGI的随机价值漂移(random value drift)可能相当令人担忧,那么未来几代人的随机价值漂移不也应该令人担忧吗?

我认为人类价值观漂移也有一定危险,但可能不如近乎命中的AGI那么危险。原因是人类大脑在生物学上非常相似,基本的人类本能似乎可能防止最糟糕形式的价值漂移。例如,很难想象在不久的将来,大多数人会想要创造尽可能多的痛苦。但如果人类未能给AGI灌输强大的"按我的意思做"的常识,那么AGI可能会犯下灾难性的错误,比如符号翻转(或更现实的变体),而没有人类心理学的护栏。(AGI肯定最终会理解人类想让它做什么,但问题是AGI是否关心这些意图。)

话虽如此,我确实认为即使在人类思想圈内的价值漂移在某些情况下也可能相当糟糕。例如,想象一下如果传统的宗教价值观在世界精英中变得更受欢迎。几千年来,直到今天,许多基督教徒和穆斯林都接受这样一种观点:不仅可以接受,而且作为全能的正义的一部分,永远折磨大多数人类是正确的,因为他们没有出生在一个信仰和实践正确宗教的文化中。

即使在现代的世界主义自由派中,报复的冲动也会时不时地抬头。在2017-2018年期间,我在互联网评论中看到许多进步人士对特朗普政府成员的个人痛苦表示幸灾乐祸。(我并不是在评判人们感到幸灾乐祸;我自己偶尔也会感到。无论如何,它通常是无害的,而且在某种程度上超出了有意识的控制。我只是指出我们人类的大脑中隐藏着许多恶毒的冲动。)

尽管如此,人类至少在未来几十年内可能在价值观变化方面处于积极轨道上,这是可信的。例如,随着世界人口的教育化程度变得更高,对传统宗教教义的信仰可能会长期继续下降,尽管在这个过程中会有许多起起落落。

致谢

本文受益于过去与Lukas Gloor、Victor Li和其他人的讨论。一些章节受到Tobias Baumann的批评启发。与Tse Yip Fai关于放生的对话启发我添加了那个主题的章节。

脚注

- 这只是一个粗略的计算,用于说明。也许模拟大脑的成本更多地与其突触数量、总质量或其他因素有关。 (返回)